5分钟学会使用 Ollama 部署 DeepSeek R1

最近 DeepSeek 风头正盛,很多人在出教程,教大家如何安装 DeepSeek,这很好。但是有一部分人把简单的事情搞的太复杂了,明明几分钟就可以搞定的事情,巴拉巴拉说了半个小时还没开始进入正题。还有一部分人在误导大家,搞的好像会部署 DeepSeek 就学会 AI 了一样,这里必须说明一下,会部署DeepSeek 学会 AI。而学会使用 AI 工具和懂 AI 原理又是两码事。

对于普通用户,其实不建议本地部署 DeepSeek,大模型对显卡要求较高。哪怕是 4090 来运行大模型,效果也没有直接使用官网的好。自己部署的话单4090只能部署一个 32b 版本,多张 4090 显卡也只能部署一个 70b 的版本,而官网和其他平台提供的 DeepSeek R1 是 671b 的满血版本,说在本地部署 DeepSeek R1 用起来能快到飞起的基本都是在扯蛋。

在官网 API 及其不稳定的情况下,拥有多张显卡的小伙伴们,本地部署一个 32b 版本或者70b 版本,来跑一些要求不太高的批量任务还是可以的。

Ollama 介绍

部署 DeepSeek 使用的是 Ollama. Ollama 是一个开源的大模型运行工具,专注于帮助用户在本地运行大型语言模型(LLMs),并且 Ollama 可以在多平台运行。

- 下载地址:https://ollama.com/download

- 文档地址:https://github.com/ollama/ollama/tree/main/docs

- Windows部署文档:https://github.com/ollama/ollama/blob/main/docs/windows.md

- Openai SDK 接入文档:https://github.com/ollama/ollama/blob/main/docs/openai.md

Ollama 安装

默认情况下 Ollama 会安装在 C 盘,并且不支持在安装界面修改安装路径。如果想要更改安装路径需要按照以下步骤来修改。

假设 Ollama 下载到了 D:\downloads 目录下。

-

打开“命令提示符”窗口 ( Win+R 然后输入

cmd) -

然后跳转到

D:\downloads(不知道如何跳转的,到这里就可以放弃了) -

通过命令行运行

OllamaSetup.exe并通过\DIR参数指定安装位置。如要安装到D:\Program Files\Ollama,则命令为:OllamaSetup.exe /DIR="D:\Program Files\Ollama"。以下是官方文档中的说明

To install the Ollama application in a location different than your home directory, start the installer with the following flag

OllamaSetup.exe /DIR="d:\some\location" -

指定模型安装位置,需要修改环境变量

OLLAMA_MODELS,将此变量指向要存储模型的位置,如果不知道默认存储在C:\Users\<user>\.ollama文件夹下。 -

在

Path环境变量中增加 Ollama 的安装路径。即增加D:\Program Files\Ollama。目的是使我们可以在命令行窗口使用ollama命令。 -

重启 Ollama。这步很重要!!!

在完成上面的步骤后 Ollama 就安装成功了。

安装模型

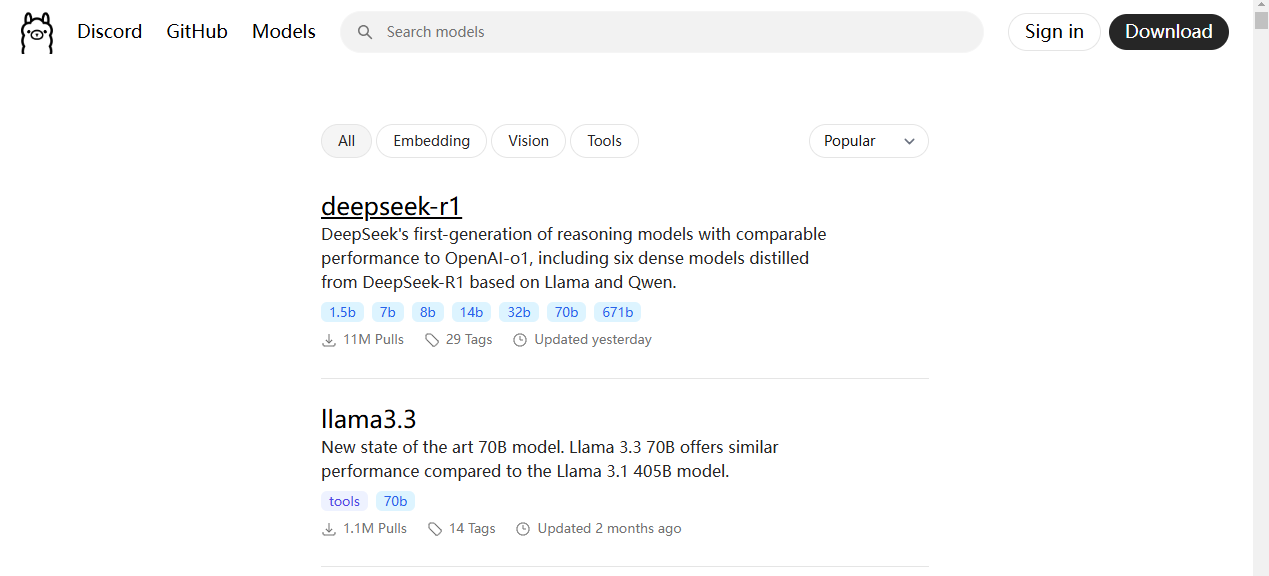

可以通过 Ollama 的 模型广场 来搜索自己需要的模型。

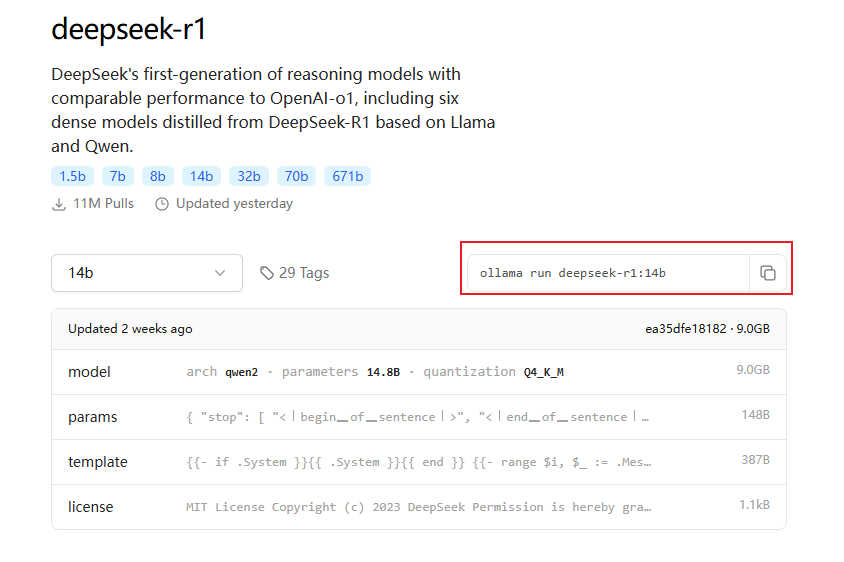

以 deepseek-r1 为例,点击进入 deepseek-r1 模型的详情页面,如下所示:

选择要安装的版本,这里选择的是 14b,然后复制右侧的命令,到命令行窗口执行。Ollama 会自动下载模型并运行。

ollama run deepseek-r1:14b

如果只想下载模型不想运行,将命令修改如下即可:

ollama pull deepseek-r1:14b

ollama 命令的使用

ollama list:列出所有本地的模型ollama ps:列出所有本地正在运行的模型ollama create:通过Modelfile安装本地模型。详细内容请查阅官方文档:https://github.com/ollama/ollama/blob/main/docs/modelfile.mdollama rm: 删除模型ollama run: 运行模型,如果模型在本地不存在会从线上拉取。ollama stop: 停止一个正在运行的模型。这里需要注意的是,如果通过 Ollama 使用了一个已经停止运行的模型,Ollama 会自动将这个模型启动。模型处于启动状态时并不会消耗 GPU 资源,只有在使用模型时才消耗,因此本地可以同时运行多个模型。

与 Chatbox 集成

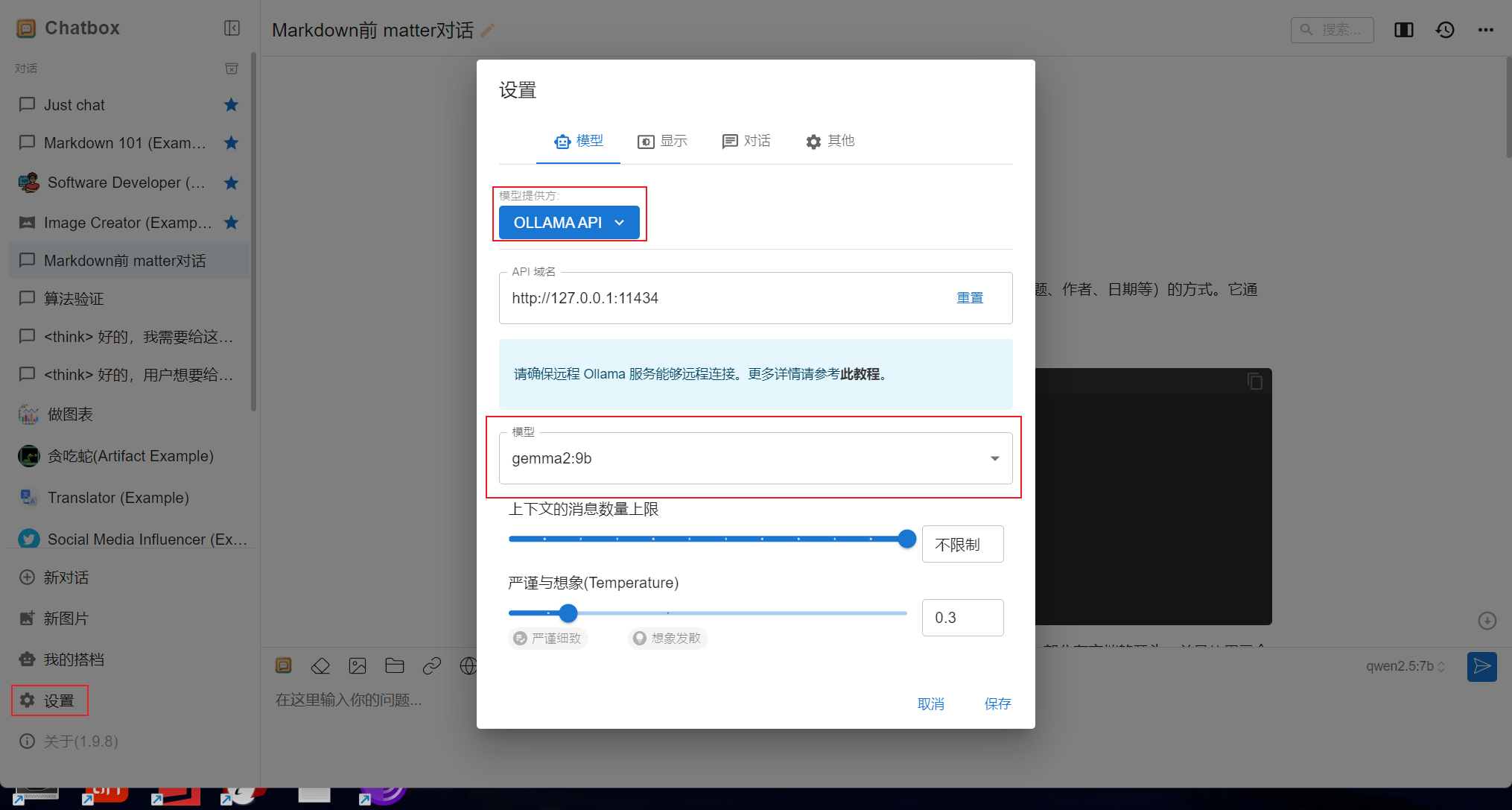

下载Chatbox:https://chatboxai.app/zh ,并安装。然后打开 Chatbox,点击左侧的 “设置” 打开设置对话框。

- 在 模型提供方 处选择:OLLAMA API

- 在 模型 处选择要使用的模型,如

deepseek-r1:14b

最后点击保存即可。

然后点击 “新对话” 打开的 Chat 窗口就是使用的本地大模型了。在 Chat 窗口中仍然可以选择大模型。

通过 API 访问模型

Ollama 兼容 Openai 的 API。 在使用时,将 base_url 指定为 http://localhost:11434/v1/ ,api_key 随便填(不能为空),即可使用像使用 Openai 的 SDK 来使用 Ollama 中的大模型。

官网文档:https://github.com/ollama/ollama/blob/main/docs/openai.md